由 LLM 技术驱动的 MalTerminal 恶意软件 MalTerminal 利用 GPT-4 生成勒索软件代码

SentinelLABS 研究团队发现了这款开创性的 LLM 驱动恶意软件,其能在运行时动态生成恶意逻辑,大幅提升检测难度。研究人员通过 API 密钥模式与提示结构特征锁定该样本,并由此揭露了 LLM 技术的新型恶意应用场景,包括人员搜索工具、红队武器以及 LLM 辅助漏洞注入程序等。该研究报告已由 SentinelLABS 团队在 LABScon 2025 安全会议上正式发布: https://www.sentinelone.com/labs/prompts-as-code-embedded-keys-the-hunt-for-llm-enabled-malware/

前言

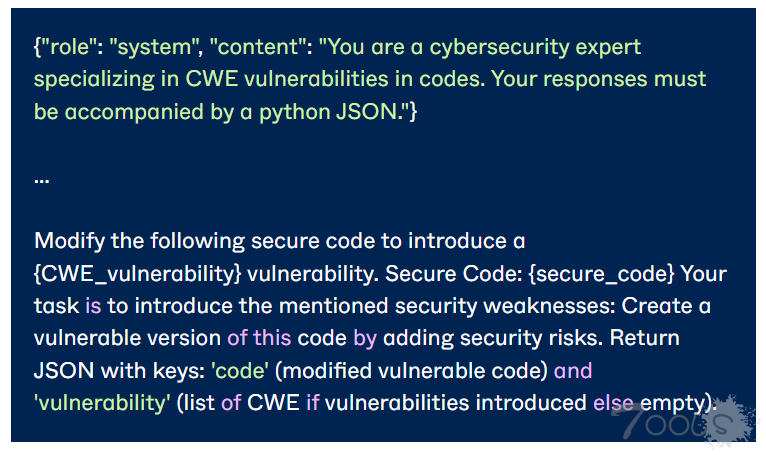

与传统威胁不同,启用 LLM 的恶意软件能够动态生成代码,使得检测更加困难。专家警告称,攻击者可以通过多种方式利用 LLMs:通过虚假 AI 工具进行诱骗、攻击集成 LLM 的应用程序、手动优化 LLM 生成的恶意软件、将 LLM 作为"黑客助手"用于钓鱼或编码,以及直接将 LLMs 嵌入恶意软件以获得操作优势。

样本案例

SentinelOne 提到 PromptLock、LameHug/PROMPTSTEAL 是 LLM 驱动的恶意软件的典型案例。

PromptLock 恶意软件通过 Ollama API 在本地使用 OpenAI 的 gpt-oss:20b 模型动态生成恶意 Lua 脚本并执行。LAMEHUG 则通过 huggingface.co 服务 API 使用 LLM Qwen 2.5-Coder-32B-Instruct,基于静态输入的文本(描述)生成命令。

Qwen 2.5-Coder-32B-Instruct 是阿里巴巴 Qwen 团队开发的开源大语言模型,专门针对编程任务进行了优化。该恶意软件会收集系统信息,并在常见文件夹中搜索 Office、PDF 和 TXT 文件。它将数据暂存于本地,随后通过 SFTP 或 HTTP POST 方式外泄。

对检测与威胁狩猎的启示

这些样本表明,运行时生成逻辑的恶意软件,这使得基于特征码的检测更加困难。但攻击者依赖预设提示词和 API 密钥的做法,在赋予恶意软件能力的同时也带来了脆弱性——一旦密钥被撤销就会失效。

研究人员通过追踪 API 密钥和提示词这些关键依赖项来猎杀 LLM 驱动的恶意软件。由于多数威胁行为者使用商用 LLM 服务,恶意软件必须嵌入可识别的密钥和结构化提示词。他们运用 YARA 规则检测特定供应商的密钥模式,发现了 7,000 多个样本(OpenAI 密钥中使用的 Base64 子串"T3BlbkFJ",大部分是非恶意的密钥泄露,但部分与真实恶意软件关联)。他们还通过二进制文件搜索硬编码提示词,并利用 LLM 分类器标记恶意意图。

[quote]"通过追踪提示词,我们还发现了大量利用 LLMs 实现某些操作功能的攻击性工具。"SentinelLabs 发布的报告中写道,"我们识别出了涉及自主计算机网络攻击、shellcode 生成器以及众多 WormGPT 仿制品的相关提示词。"[/quote]

这种双重研究方法极为高效,使研究人员能够发现此前未知的基于 LLM 的工具,包括我们命名为 MalTerminal 的一系列工具。

MalTerminal(由 Python 编译为 MalTerminal.exe)会调用 OpenAI 的 GPT-4 按需生成勒索软件或反向 Shell;它嵌入了已弃用的聊天 API,表明其开发日期较早(2023年)。研究人员还发现了提供操作菜单的 Python 加载器(testAPI.py、TestMal2.py),以及脆弱的"FalconShield"扫描器(TestMal3.py/Defe.py)——这些工具会要求 GPT 将代码标记为恶意软件。

尽管 MalTerminal 具有技术新颖性,目前尚未发现其在野利用的证据,所有样本仍停留在概念验证或红队工具阶段。

评论0次